OpenRouter: LLM을 위한 통합 인터페이스

여러분이 이미 OpenAI API를 시스템에 통합했는데, Google Gemini와 Anthropic API도 함께 사용하고 싶다고 상상해보세요. 각 제공업체마다 별도의 계정을 만들고, 여러 SDK를 관리하며, 코드를 더 복잡하게 만들겠습니까? 아니면 단일 코드 라인으로 모든 제공업체의 대규모 언어 모델(LLM)에 접근할 수 있는 통합 솔루션을 선호하시겠습니까?

이 튜토리얼에서는 개발자가 여러 AI 모델에 접근할 수 있는 통합 인터페이스를 제공하여 개발자의 삶을 단순화하도록 설계된 플랫폼인 OpenRouter를 살펴보겠습니다. OpenRouter를 설정하고, Python의 requests 라이브러리와 OpenAI 클라이언트를 사용하여 모델에 접근하는 방법, 그리고 OpenRouter가 워크플로우를 간소화하는 방법을 알아보겠습니다.

OpenRouter 소개

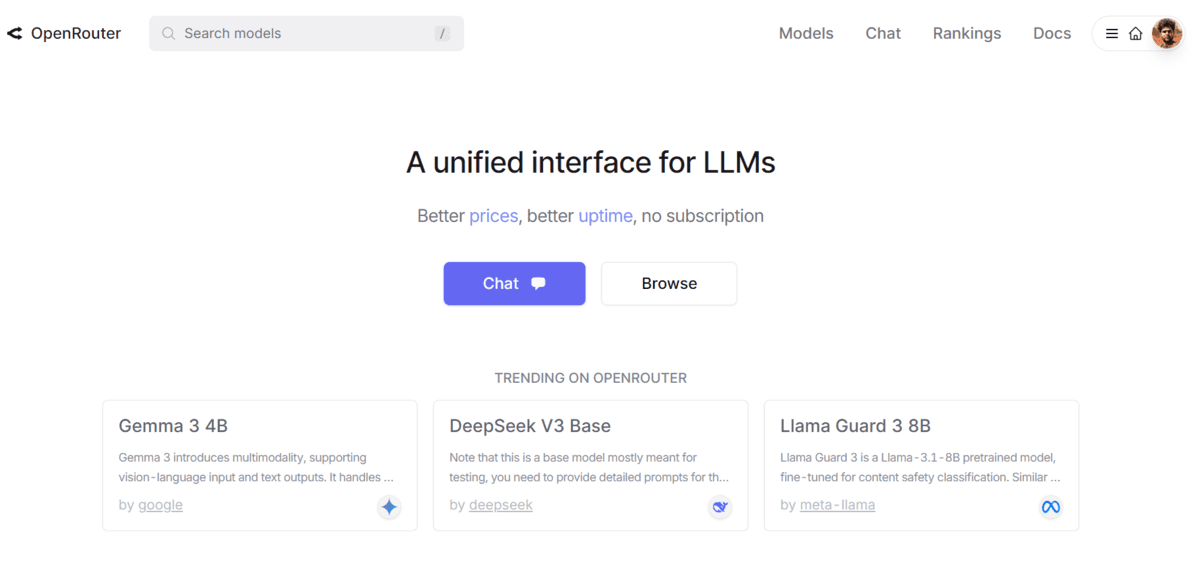

OpenRouter는 개발자에게 OpenAI, Anthropic, Google, Meta, Mistral 등 주요 AI 제공업체의 다양한 LLM에 대한 접근을 제공하는 통합 API 플랫폼입니다. 이 플랫폼은 이러한 모델을 애플리케이션에 통합하기 위한 단일화되고 표준화된 인터페이스를 제공하여 여러 AI 서비스 작업 과정을 단순화합니다. OpenRouter는 자동으로 대체(fallback)를 처리하여 신뢰성을 보장하고, 가장 비용 효율적인 옵션을 선택하여 시간과 자원을 절약합니다. 개발자는 몇 줄의 코드만으로 원하는 SDK나 프레임워크를 사용하여 시작할 수 있어 접근성이 높고 구현이 쉽습니다.

OpenRouter 설정하기

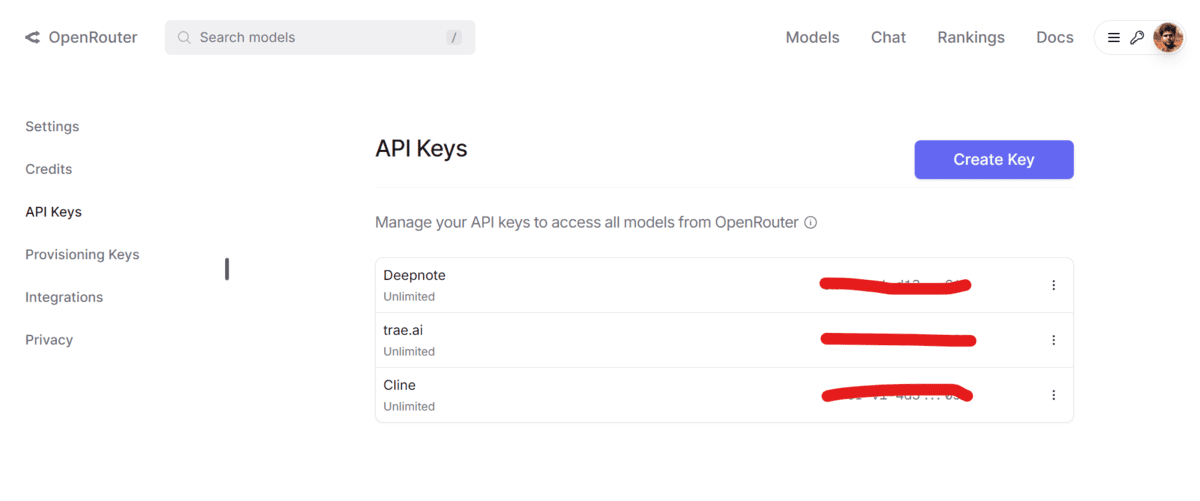

OpenRouter 웹사이트를 방문하여 계정에 가입하세요. 계정이 생성되면 API 섹션으로 이동하여 API 키를 생성하세요.

보안과 사용 편의성을 위해 API 키를 시스템의 환경 변수로 저장하세요. 이렇게 하면 스크립트에 민감한 정보를 하드코딩하지 않고도 프로그래밍 방식으로 API 키에 접근할 수 있습니다.

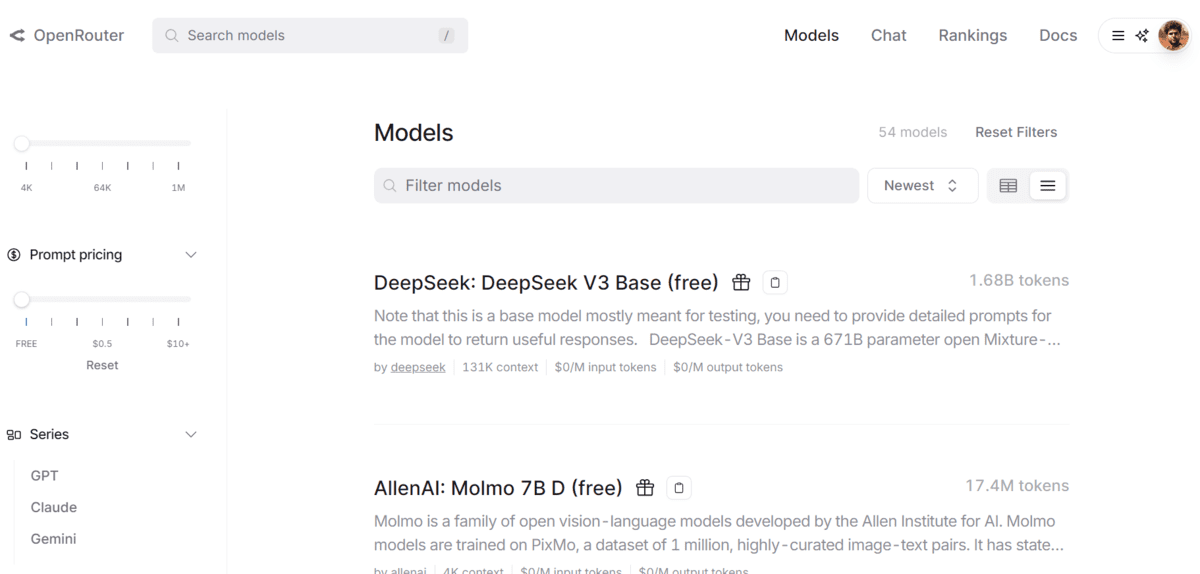

OpenRouter는 다양한 AI 모델을 위한 마켓플레이스 역할을 하여 다양한 옵션을 탐색하고 선택할 수 있게 해줍니다. 모델을 검색하고, 제공된 API 코드를 복사하여 터미널이나 애플리케이션에서 직접 테스트할 수 있습니다.

OpenRouter 사용하기

Python, OpenAI 클라이언트, TypeScript 또는 cURL 명령을 사용하여 OpenRouter와 상호 작용할 수 있습니다. 이 섹션에서는 Python `requests` 라이브러리와 OpenAI 클라이언트를 사용하여 OpenRouter API에 접근하고 통합 과정을 단순화하는 방법을 보여드리겠습니다.

Requests를 사용하여 OpenRouter 접근하기

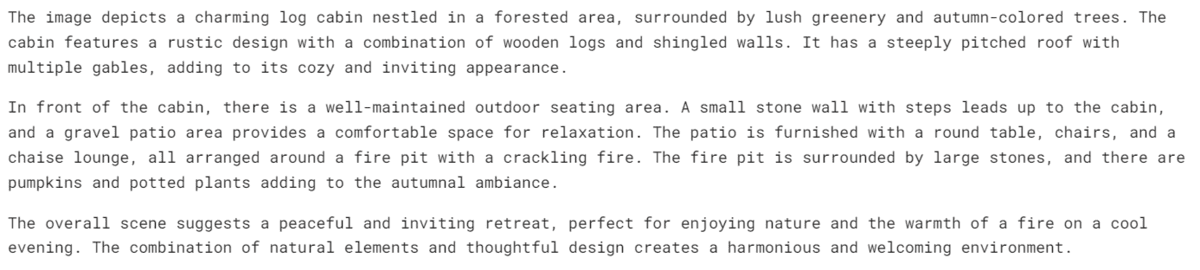

Python requests 라이브러리는 OpenRouter API와 상호 작용하는 간단하고 효과적인 방법입니다. 아래는 텍스트와 이미지 입력의 조합을 `qwen2.5-vl-72b-instruct` 모델에 제공하기 위해 OpenRouter 서버에 요청을 보내는 예시입니다.

```python

from IPython.display import display, Markdown

import requests

import json

import os

API_KEY = os.environ["OPENROUTER"]

response = requests.post(

url="https://openrouter.ai/api/v1/chat/completions",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json",

},

data=json.dumps({

"model": "qwen/qwen2.5-vl-72b-instruct:free",

"messages": [

{

"role": "user",

"content": [

{

"type": "text",

"text": "Explain the image."

},

{

"type": "image_url",

"image_url": {

"url": "https://www.familyhandyman.com/wp-content/uploads/2018/02/handcrafted-log-home.jpg"

}

}

]

}

],

})

)

Parse the JSON response

result = response.json()

Extract and print the model's response text

output = result["choices"][0]["message"]["content"]

display(Markdown(output))

```

빠르고 정확한 응답을 얻을 수 있습니다.

OpenAI 클라이언트를 사용하여 OpenRouter에 접근하기

이미 OpenAI 클라이언트에 익숙하다면, 이를 사용하여 OpenRouter API에 접근할 수 있습니다. 먼저 아직 설치하지 않았다면 OpenAI 클라이언트를 설치하세요:

```

pip install openai

```

그런 다음, 다음 코드를 사용하여 OpenRouter 서버에 요청을 보내세요. 이번에는 `deepseek-chat-v3-0324` 모델을 사용합니다.

```python

from openai import OpenAI

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key=os.environ["OPENROUTER"],

)

completion = client.chat.completions.create(

model="deepseek/deepseek-chat-v3-0324:free",

messages=[

{

"role": "user",

"content": "Create beautiful ASCII art."

}

]

)

output = completion.choices[0].message.content

display(Markdown(output))

```

동일한 URL과 API 키를 사용하여 모델에 성공적으로 접근했으며, 이는 모델 이름을 변경하는 것만으로 어떤 모델에도 접근할 수 있다는 것을 의미합니다.

OpenRouter 주요 기능

OpenRouter의 주요 기능을 한눈에 살펴보세요:

1. 다중 모델을 위한 통합 API

- OpenAI, Anthropic, Mistral, Meta, Google 등의 모델에 단일 API 엔드포인트로 접근 가능

- 여러 키나 제공업체별 SDK를 관리할 필요 없음

2. 모델 라우팅 및 장애 조치

- 사용 가능한 모델로 자동 요청 라우팅

- 대체(fallback) 및 제공업체 간 부하 분산 지원

3. OpenAI 호환 SDK

- 드롭인 대체: 기존 OpenAI 기반 코드베이스를 최소한의 변경으로 OpenRouter로 쉽게 전환

- openai와 같은 인기 있는 Python 클라이언트와 호환

4. 투명한 종량제 가격

- 추론 비용에 마크업 없음 - 모델 제공업체에서 직접 가격 책정

- 한 곳에서 모델 간 토큰 가격을 비교하고 확인 가능

5. 보안 API 키 및 속도 제어

- 특정 권한, 사용 제한 또는 만료 날짜가 있는 API 키 생성

- 대시보드를 통한 사용량 모니터링

6. 분석 및 모니터링

- 대시보드는 사용량, 지연 시간 및 모델 성능에 대한 인사이트 제공

- 디버깅 및 최적화에 유용

7. 모델 사용자 정의

- 모델 ID별로 트래픽을 라우팅하거나 기본 모델 구성 가능

- 사용자 정의 프롬프트, 템플릿 및 헤더 지원

결론

OpenRouter의 설정, 결제 프로세스, 인터페이스가 단순하면서도 강력한 기능을 갖추고 있다는 점이 인상적입니다. 개발자가 API를 전환하거나 코드를 다시 작성할 필요 없이 최고의 모델에 접근할 수 있게 해주는 통합 마켓플레이스 역할을 함으로써 AI 생태계의 중요한 격차를 메웁니다. 몇 가지 조정만으로 다양한 LLM에 접근하고, 비용과 성능을 최적화하며, 그 어느 때보다 효율적으로 AI 통합을 확장할 수 있습니다.