WTF is a Transformer?

Introducing the Transformer

트랜스포머는 딥러닝 아키텍처이자 고급 자연어 처리(NLP) 솔루션이며, ChatGPT와 같은 강력한 모델의 내부 구조입니다.

최근까지 텍스트 번역이나 감정 분석과 같은 전통적인 NLP 작업은 순환 신경망(recurrent neural networks)과 같은 딥러닝 모델을 통해 처리되었습니다. 이러한 아키텍처는 순차 데이터 모델링에 일정한 성공을 거두었지만, 중요한 한계점도 있었습니다. 긴 텍스트를 분석할 때 장거리 의존성을 처리하는 데 어려움을 겪었고, 문장이나 단락의 먼 부분 사이의 관계를 포착하지 못했습니다. 또한 순차적 특성으로 인해 긴 시퀀스를 처리할 때 느리고 비효율적이었습니다.

트랜스포머는 이러한 한계를 극복하기 위해 지난 10년 말에 혁신적인 아키텍처로 등장했습니다.

이 글에서는 트랜스포머가 무엇인지, 어떻게 시작되었는지, 왜 대규모 언어 모델(LLM)을 포함한 혁신적인 AI 발전을 이끌었는지, 그리고 NLP 내외의 응용 분야에 대해 알아보겠습니다.

Depicting the Transformer

트랜스포머는 텍스트와 같은 비구조화된 데이터에서 효과적인 패턴 인식과 인간 언어를 이해하고 생성하는 능력을 결합한 딥러닝 기반 아키텍처입니다. 원래 언어 이해와 생성을 포함하는 시퀀스-투-시퀀스 작업(예: 한 언어에서 다른 언어로 텍스트 번역, 긴 글 요약)을 처리하기 위해 설계되었습니다.

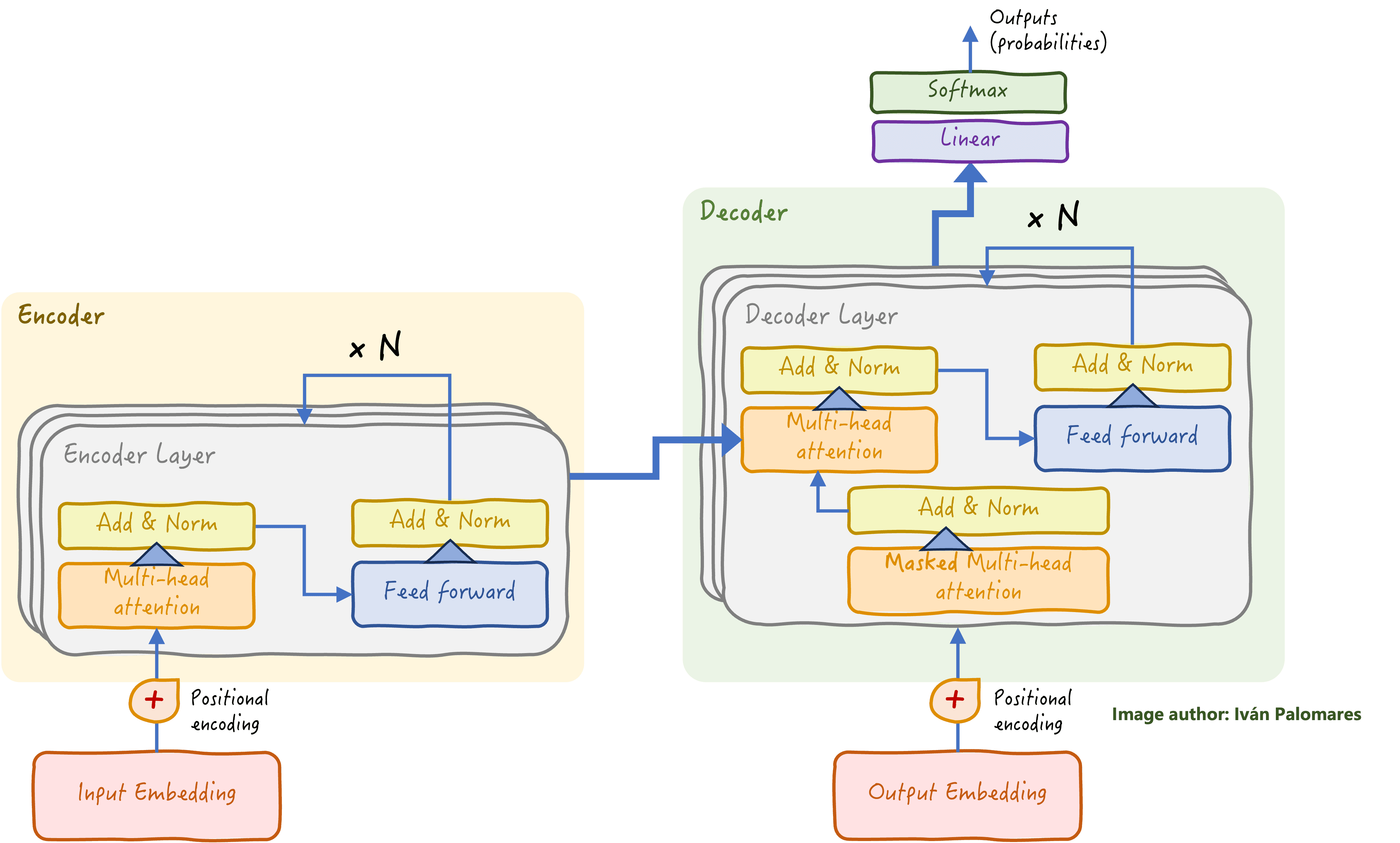

트랜스포머 아키텍처는 크게 인코더와 디코더 두 가지 주요 블록으로 나뉩니다.

트랜스포머가 이전에 없던 수준으로 복잡한 NLP 작업을 효과적으로 처리할 수 있게 하는 것은 주의 메커니즘(위 다이어그램의 멀티헤드 어텐션 블록 참조)이라는 구성 요소를 사용하기 때문입니다. 주의 메커니즘, 특히 멀티헤드 어텐션이라는 고급 형태는 트랜스포머 모델에 위치에 관계없이 문장의 다른 단어와 부분 사이의 관계를 포착하고 그 중요성을 가중치를 부여하는 능력을 제공합니다. 멀티헤드 어텐션 메커니즘을 통해 트랜스포머의 각 "어텐션 헤드"는 구문, 의미론 등 언어의 특정 측면을 포착하는 데 특화되어 있습니다. 이는 우리 인간이 멀리 떨어져 있는 언어 조각을 연결하여 문장의 정확한 의미를 파악하기 위해 핵심 요소에 집중하는 방식과 유사합니다.

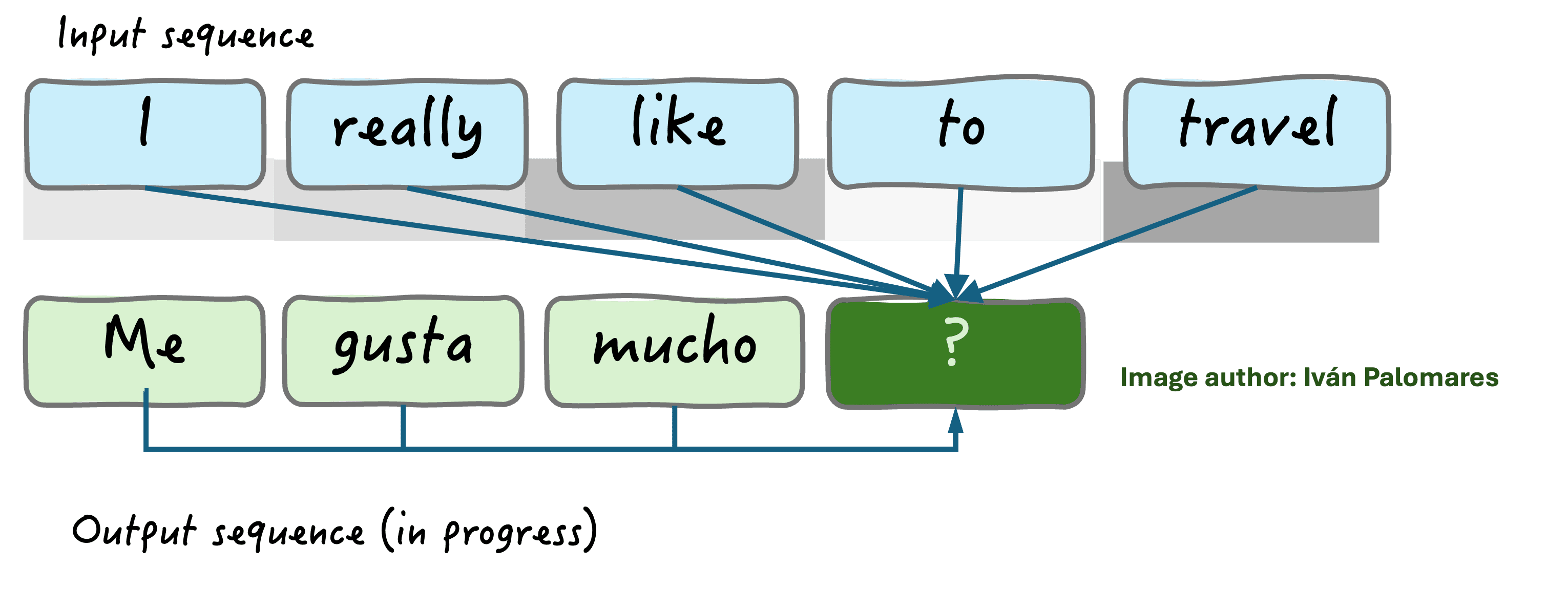

주의 메커니즘은 디코더 부분에도 배치되어 입력 요소와 단어별로 생성되는 출력 사이의 상호 관계를 포착합니다. 아래 그림의 예는 이 원리를 보여줍니다: 주의 메커니즘은 스페인어 번역으로 구성된 출력 시퀀스에서 다음에 올 단어를 추론하기 위해 "like"와 "travel"이라는 단어를 가장 관련성 높은 것으로 식별합니다. 입력 단어 아래의 회색 수준은 출력과의 관계 강도를 나타냅니다.

Transformers in the Real World: Applications in NLP and Beyond

트랜스포머 아키텍처는 AI와 머신러닝 전체 환경을 혁신하여 지난 몇 년 동안 발전 방향을 크게 형성했습니다. 이 아키텍처가 가져온 가장 혁신적인 발전에는 GPT, BERT 및 T5와 같은 LLM이 포함되며, 이를 통해 기계가 인간 언어를 이해하고 생성하는 능력이 극적으로 향상되었고 ChatGPT와 Claude 같은 강력한 대화형 AI 솔루션을 지원하게 되었습니다.

트랜스포머의 실제 응용 분야는 AI 기반 챗봇과 실시간 번역 도구부터 LLM을 복잡한 검색 시스템(RAG)에 통합하는 더 똑똑한 검색 엔진, 문법 교정, 콘텐츠 요약, 창의적인 글쓰기에 이르기까지 다양합니다.

그러나 트랜스포머는 복잡한 NLP 작업을 처리하는 데만 적합한 것이 아닙니다. 이미지 및 비디오 데이터의 패턴을 인식하는 데 사용되는 컴퓨터 비전과 같은 다른 도메인에서도 효과적임이 입증되었습니다. 또한 단백질 구조 예측과 같은 작업을 위한 생물학 분야에서도 그 가치를 입증했습니다. 다양한 유형의 데이터와 작업에 걸친 이러한 적응성은 트랜스포머 아키텍처를 매우 강력하고 광범위하게 만드는 요소 중 하나입니다.

그럼에도 불구하고, 기존 머신러닝 모델이 더 적합한 일부 시나리오에서는 한계가 있습니다. 예를 들어, 예측 성격의 분류 및 회귀 문제를 위한 작은 구조화된 데이터셋으로 작업할 때나 모델 해석 가능성이 우선순위일 때가 그렇습니다.

Wrapping Up

트랜스포머는 전통적인 모델의 한계를 극복하고 언어 처리부터 컴퓨터 비전에 이르기까지 모든 분야에서 혁신을 이끌면서 AI 환경을 완전히 재구성했습니다. 멀티헤드 주의 메커니즘을 통해 미묘하고 장거리 의존성을 포착할 수 있어 복잡한 데이터를 이해하고 생성하는 데 능숙합니다.

복잡성을 명확성으로 바꾸는 것에 관해서라면, 트랜스포머는 정말로 게임을 바꾸는 방법을 알고 있습니다.